Redis实现的分布式锁2

引言

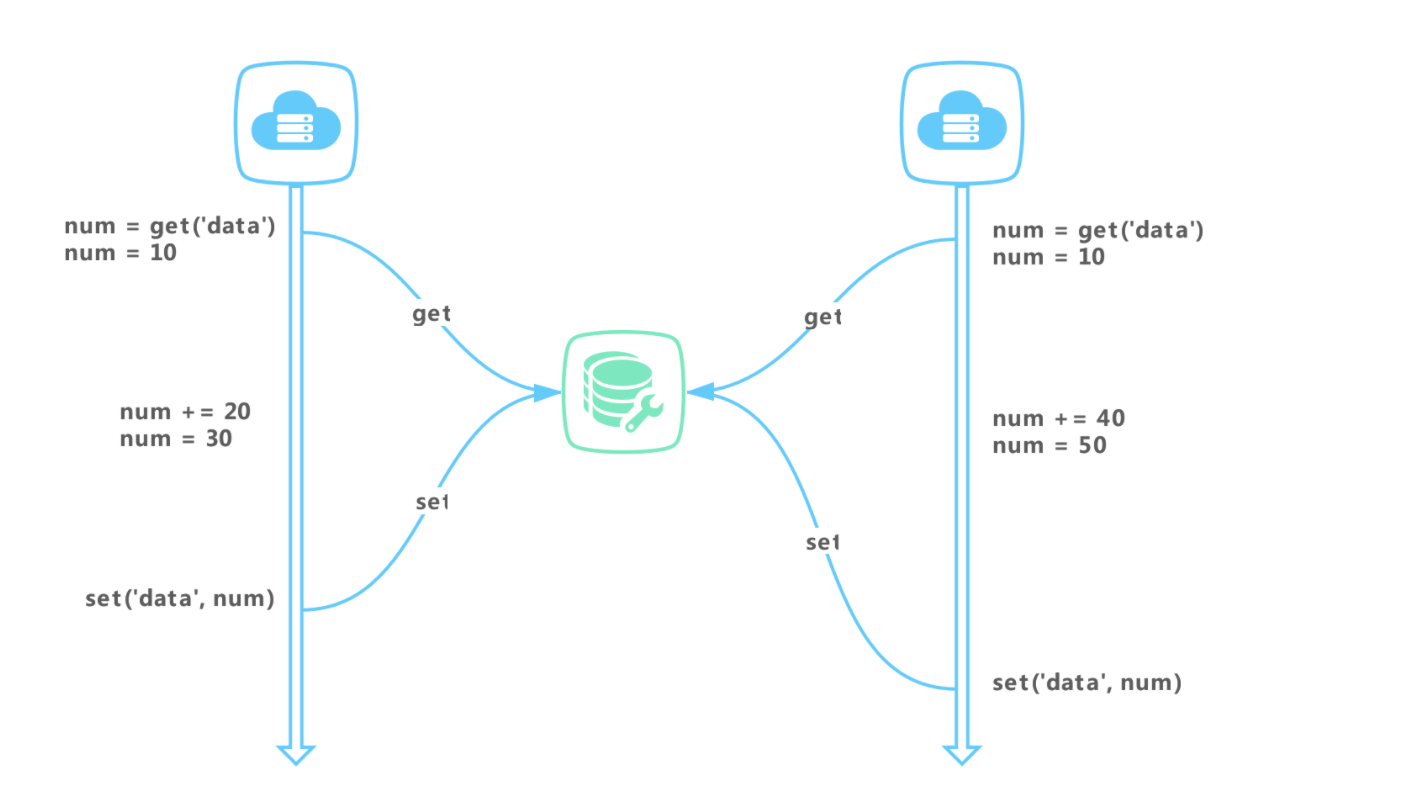

我们在系统中修改已有数据时,需要先读取,然后进行修改保存,此时很容易遇到并发问题。由于修改和保存不是原子操作,在并发场景下,部分对数据的操作可能会丢失。在单服务器系统我们常用本地锁来避免并发带来的问题,然而,当服务采用集群方式部署时,本地锁无法在多个服务器之间生效,这时候保证数据的一致性就需要分布式锁来实现。

实现

Redis 锁主要利用 Redis 的 setnx 命令。

- 加锁命令:SETNX key value,当键不存在时,对键进行设置操作并返回成功,否则返回失败。KEY 是锁的唯一标识,一般按业务来决定命名。

- 解锁命令:DEL key,通过删除键值对释放锁,以便其他线程可以通过 SETNX 命令来获取锁。

- 锁超时:EXPIRE key timeout, 设置 key 的超时时间,以保证即使锁没有被显式释放,锁也可以在一定时间后自动释放,避免资源被永远锁住。

则加锁解锁伪代码如下:

if (setnx(key, 1) == 1){

expire(key, 30)

try {

//TODO 业务逻辑

} finally {

del(key)

}

}

上述锁实现方式存在一些问题:

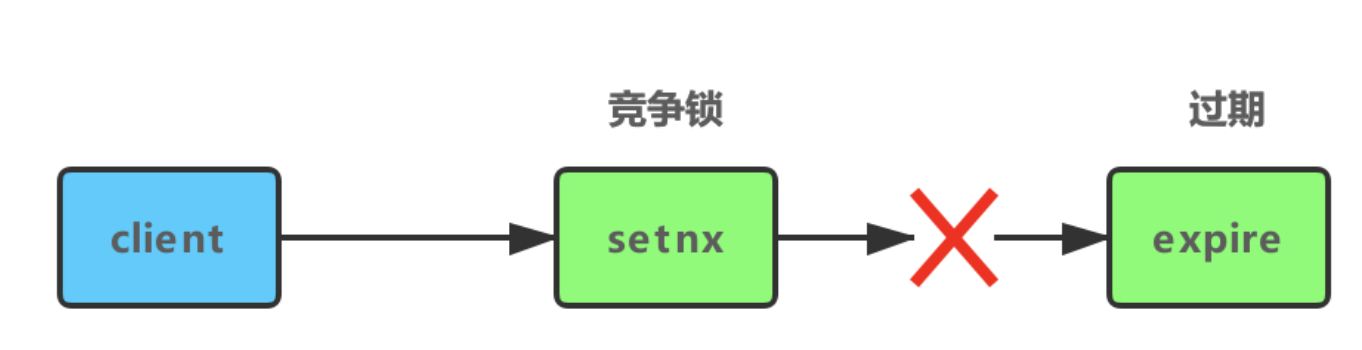

1、SETNX 和 EXPIRE 非原子性(服务器挂了,锁没释放)

如果 SETNX 成功,在设置锁超时时间后,服务器挂掉、重启或网络问题等,导致 EXPIRE 命令没有执行,锁没有设置超时时间变成死锁。

有很多开源代码来解决这个问题,比如使用 lua 脚本。示例:

if (redis.call('setnx', KEYS[1], ARGV[1]) < 1)

then return 0;

end;

redis.call('expire', KEYS[1], tonumber(ARGV[2]));

return 1;

// 使用实例

EVAL "if (redis.call('setnx',KEYS[1],ARGV[1]) < 1) then return 0; end; redis.call('expire',KEYS[1],tonumber(ARGV[2])); return 1;" 1 key value 100

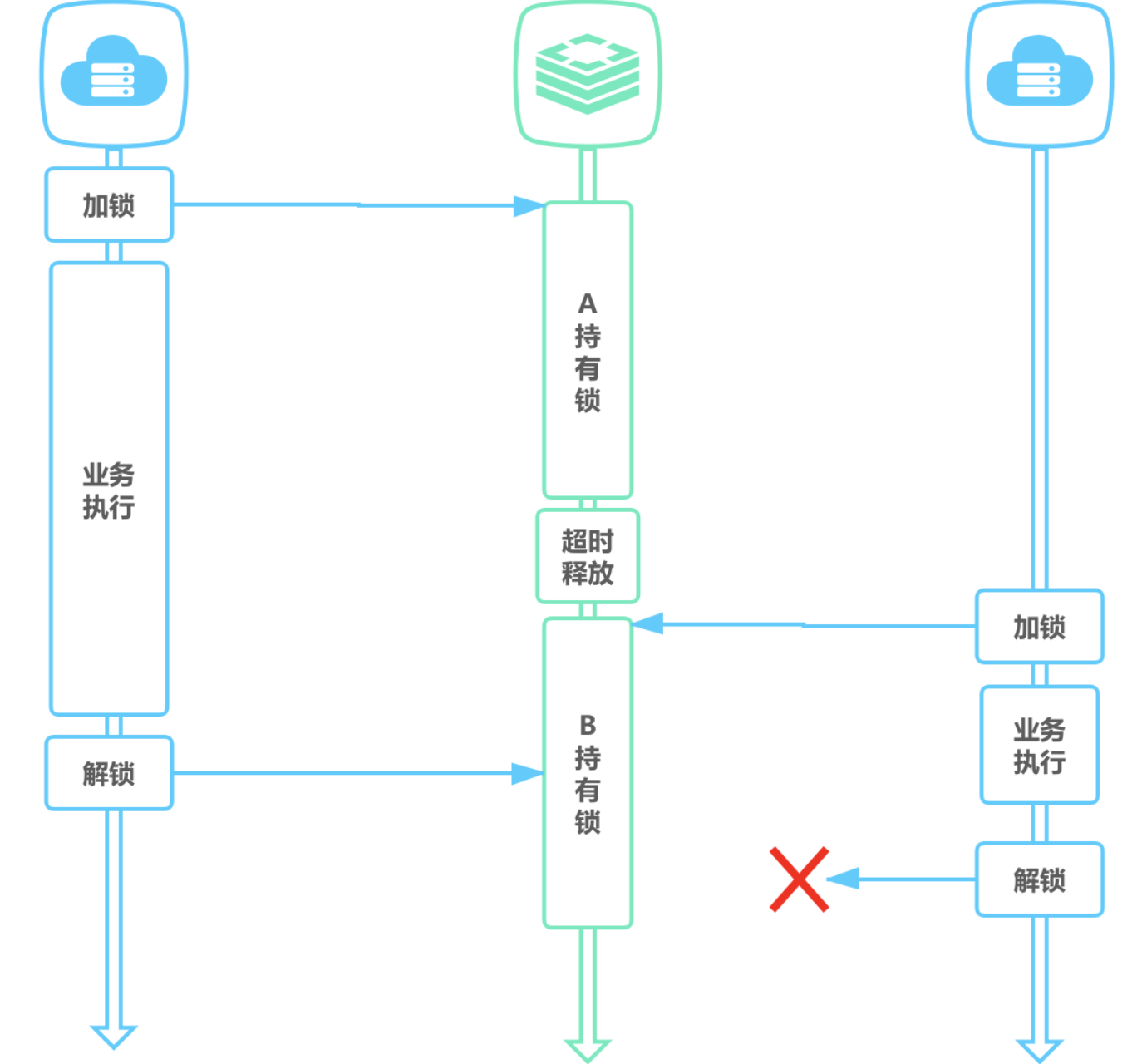

2、锁误解除

如果线程 A 成功获取到了锁,并且设置了过期时间 30 秒,但线程 A 执行时间超过了 30 秒,锁过期自动释放,此时线程 B 获取到了锁;随后 A 执行完成,线程 A 使用 DEL 命令来释放锁,但此时线程 B 加的锁还没有执行完成,线程 A 实际释放的线程 B 加的锁。

通过在 value 中设置当前线程加锁的标识,在删除之前验证 key 对应的 value 判断锁是否是当前线程持有。可生成一个 UUID 标识当前线程,使用 lua 脚本做验证标识和解锁操作。

// 加锁

String uuid = UUID.randomUUID().toString().replaceAll("-","");

SET key uuid NX EX 30

// 解锁

if (redis.call('get', KEYS[1]) == ARGV[1])

then return redis.call('del', KEYS[1])

else return 0

end

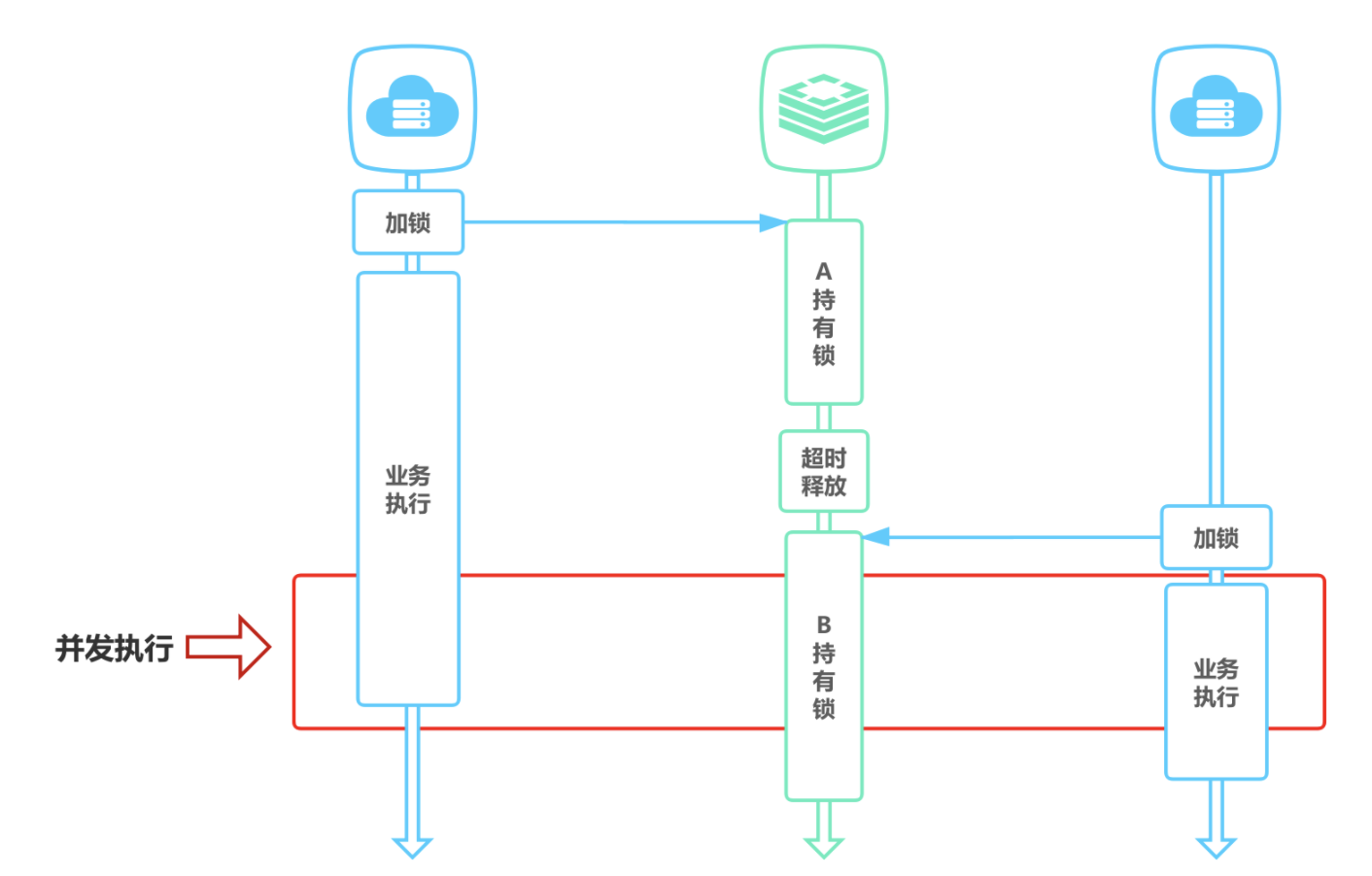

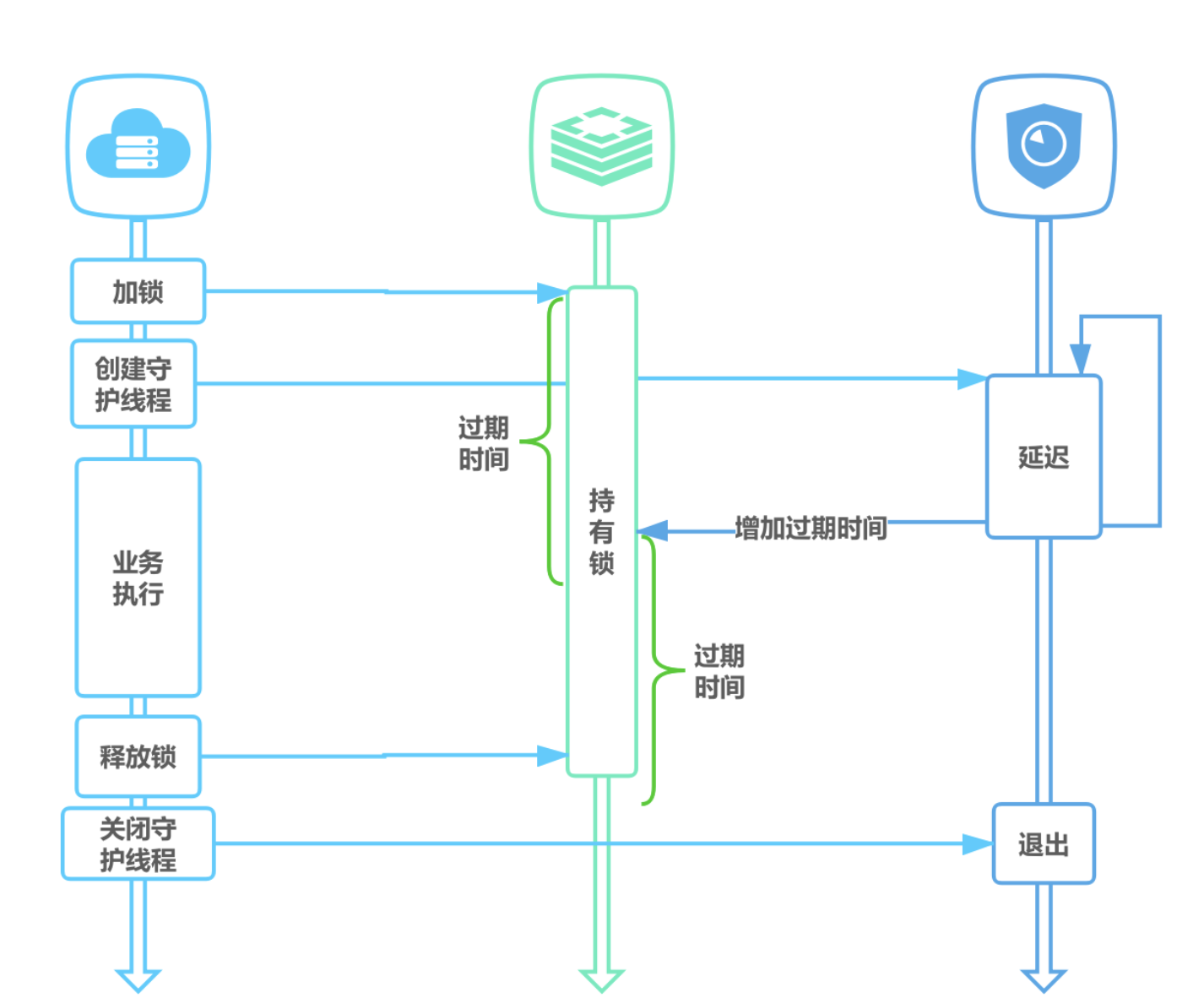

3、超时解锁导致并发

如果线程 A 成功获取锁并设置过期时间 30 秒,但线程 A 执行时间超过了 30 秒,锁过期自动释放,此时线程 B 获取到了锁,线程 A 和线程 B 并发执行。

A、B 两个线程发生并发显然是不被允许的,一般有两种方式解决该问题:

- 将过期时间设置足够长,确保代码逻辑在锁释放之前能够执行完成。

- 为获取锁的线程增加守护线程,为将要过期但未释放的锁增加有效时间。

4、不可重入

当线程在持有锁的情况下再次请求加锁,如果一个锁支持一个线程多次加锁,那么这个锁就是可重入的。如果一个不可重入锁被再次加锁,由于该锁已经被持有,再次加锁会失败。Redis 可通过对锁进行重入计数,加锁时加 1,解锁时减 1,当计数归 0 时释放锁。

在本地记录记录重入次数,如 Java 中使用 ThreadLocal 进行重入次数统计,简单示例代码:

private static ThreadLocal<Map<String, Integer>> LOCKERS = ThreadLocal.withInitial(HashMap::new);

// 加锁

public boolean lock(String key) {

Map<String, Integer> lockers = LOCKERS.get();

if (lockers.containsKey(key)) {

lockers.put(key, lockers.get(key) + 1);

return true;

} else {

if (SET key uuid NX EX 30) {

lockers.put(key, 1);

return true;

}

}

return false;

}

// 解锁

public void unlock(String key) {

Map<String, Integer> lockers = LOCKERS.get();

if (lockers.getOrDefault(key, 0) <= 1) {

lockers.remove(key);

DEL key

} else {

lockers.put(key, lockers.get(key) - 1);

}

}

本地记录重入次数虽然高效,但如果考虑到过期时间和本地、Redis 一致性的问题,就会增加代码的复杂性。另一种方式是 Redis Map 数据结构来实现分布式锁,既存锁的标识也对重入次数进行计数。Redission 加锁示例:

// 如果 lock_key 不存在

if (redis.call('exists', KEYS[1]) == 0)

then

// 设置 lock_key 线程标识 1 进行加锁

redis.call('hset', KEYS[1], ARGV[2], 1);

// 设置过期时间

redis.call('pexpire', KEYS[1], ARGV[1]);

return nil;

end;

// 如果 lock_key 存在且线程标识是当前欲加锁的线程标识

if (redis.call('hexists', KEYS[1], ARGV[2]) == 1)

// 自增

then redis.call('hincrby', KEYS[1], ARGV[2], 1);

// 重置过期时间

redis.call('pexpire', KEYS[1], ARGV[1]);

return nil;

end;

// 如果加锁失败,返回锁剩余时间

return redis.call('pttl', KEYS[1]);

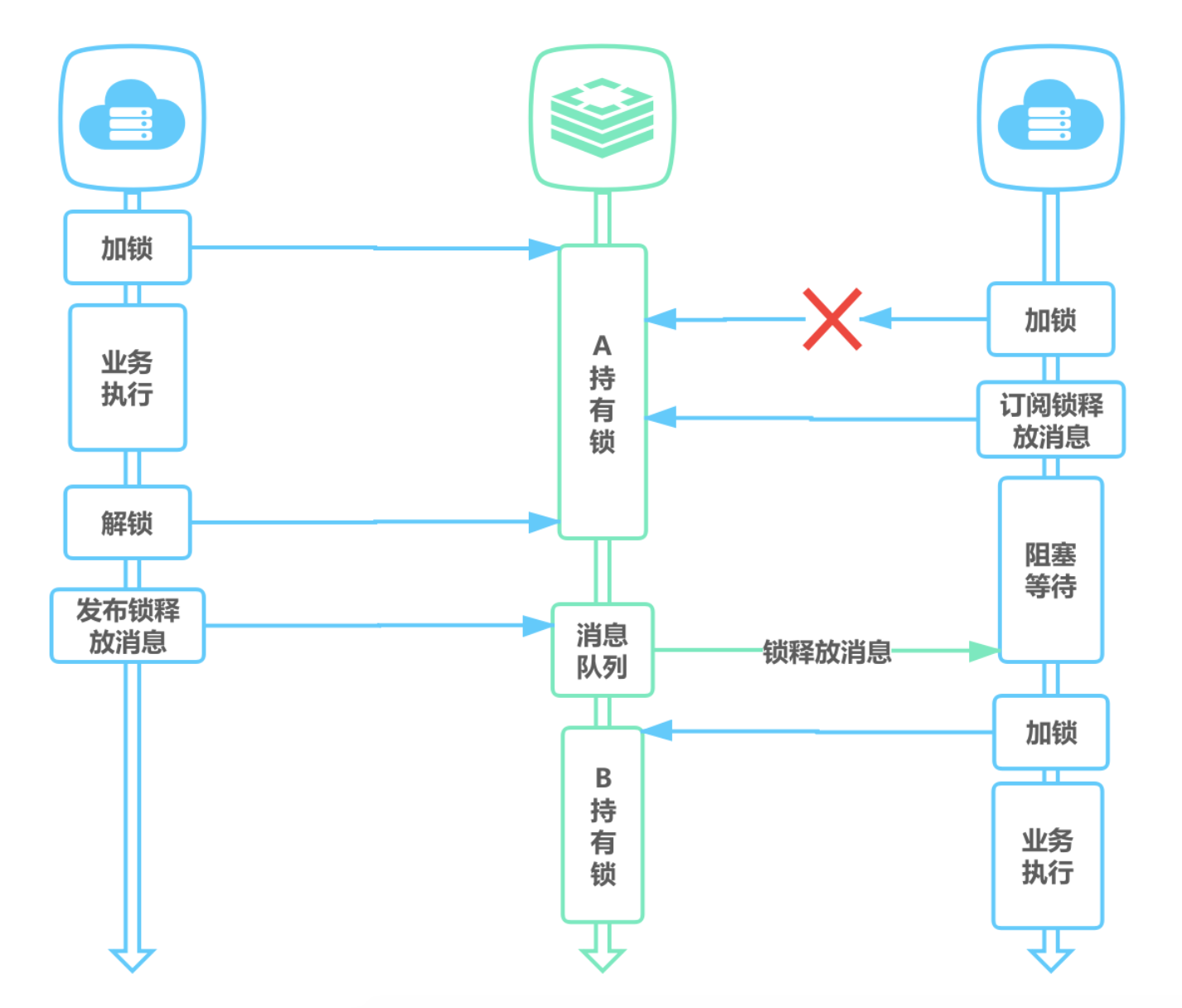

5、无法等待锁释放

上述命令执行都是立即返回的,如果客户端可以等待锁释放就无法使用。

- 可以通过客户端轮询的方式解决该问题,当未获取到锁时,等待一段时间重新获取锁,直到成功获取锁或等待超时。这种方式比较消耗服务器资源,当并发量比较大时,会影响服务器的效率。

- 另一种方式是使用 Redis 的发布订阅功能,当获取锁失败时,订阅锁释放消息,获取锁成功后释放时,发送锁释放消息。如下:

集群

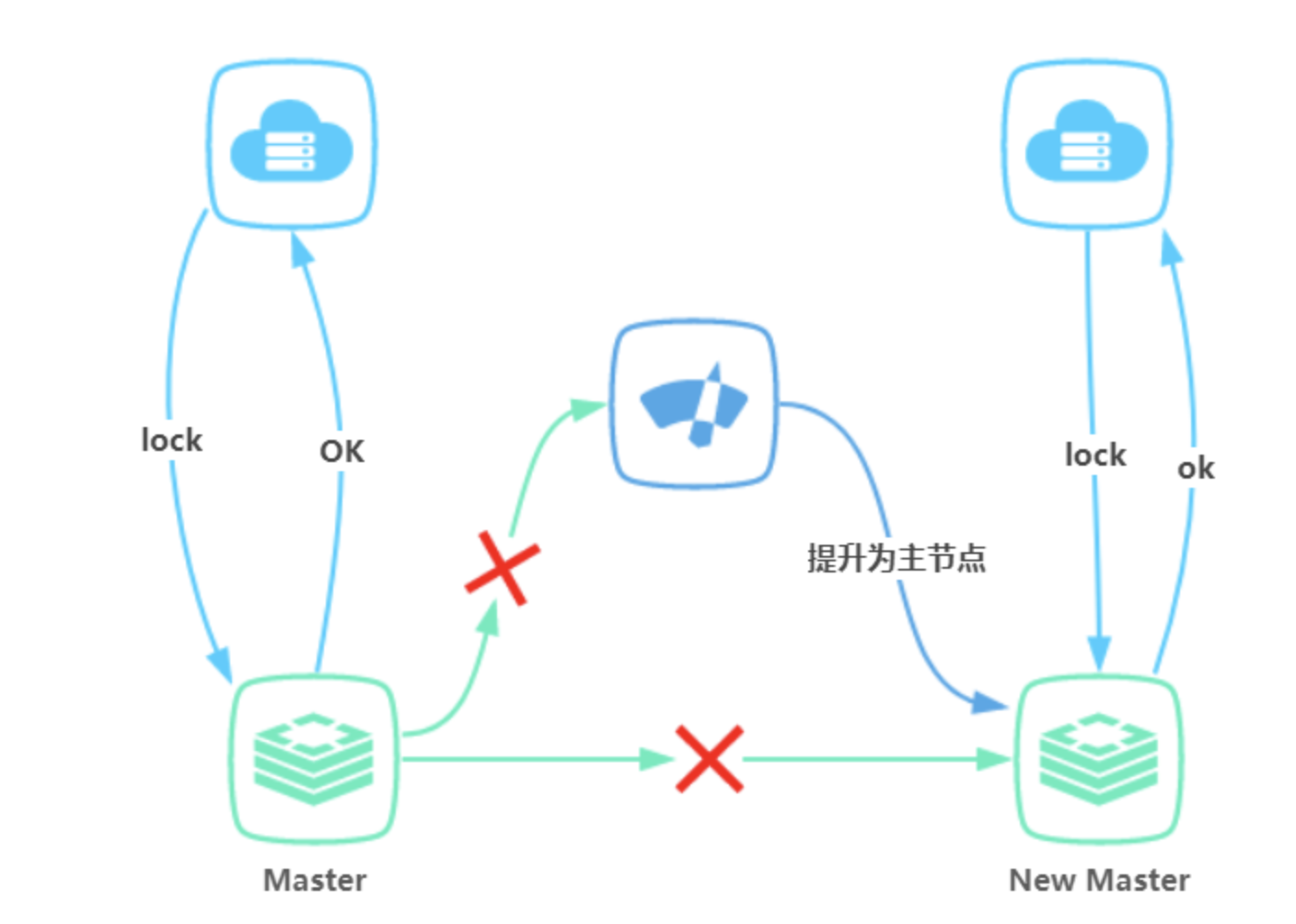

1. 主备切换

为了保证 Redis 的可用性,一般采用主从方式部署。主从数据同步有异步和同步两种方式,Redis 将指令记录在本地内存 buffer 中,然后异步将 buffer 中的指令同步到从节点,从节点一边执行同步的指令流来达到和主节点一致的状态,一边向主节点反馈同步情况。

解决主从架构的redis分布式锁主节点宕机锁丢失的问题

RedLock算法的核心原理:

使用N个完全独立、没有主从关系的Redis master节点以保证他们大多数情况下都不会同时宕机,N一般为奇数。一个客户端需要做如下操作来获取锁:

- 获取当前时间(单位是毫秒)。

- 轮流用相同的key和随机值在N个节点上请求锁,在这一步里,客户端在每个master上请求锁时,会有一个和总的锁释放时间相比小的多的超时时间。比如如果锁自动释放时间是10秒钟,那每个节点锁请求的超时时间可能是5-50毫秒的范围,这个可以防止一个客户端在某个宕掉的master节点上阻塞过长时间,如果一个master节点不可用了,我们应该尽快尝试下一个master节点。

- 客户端计算第二步中获取锁所花的时间,只有当客户端在大多数master节点上成功获取了锁((N/2) +1),而且总共消耗的时间不超过锁释放时间,这个锁就认为是获取成功了。

- 如果锁获取成功了,那现在锁自动释放时间就是最初的锁释放时间减去之前获取锁所消耗的时间。

- 如果锁获取失败了,不管是因为获取成功的锁不超过一半(N/2+1)还是因为总消耗时间超过了锁释放时间,客户端都会到每个master节点上释放锁,即便是那些他认为没有获取成功的锁。

**简单来说,就是利用多个的主节点,在超过半数以上的主节点获取锁成功,才算成功;否则算失败,回滚–删除之前在所有节点上获取的锁。 **

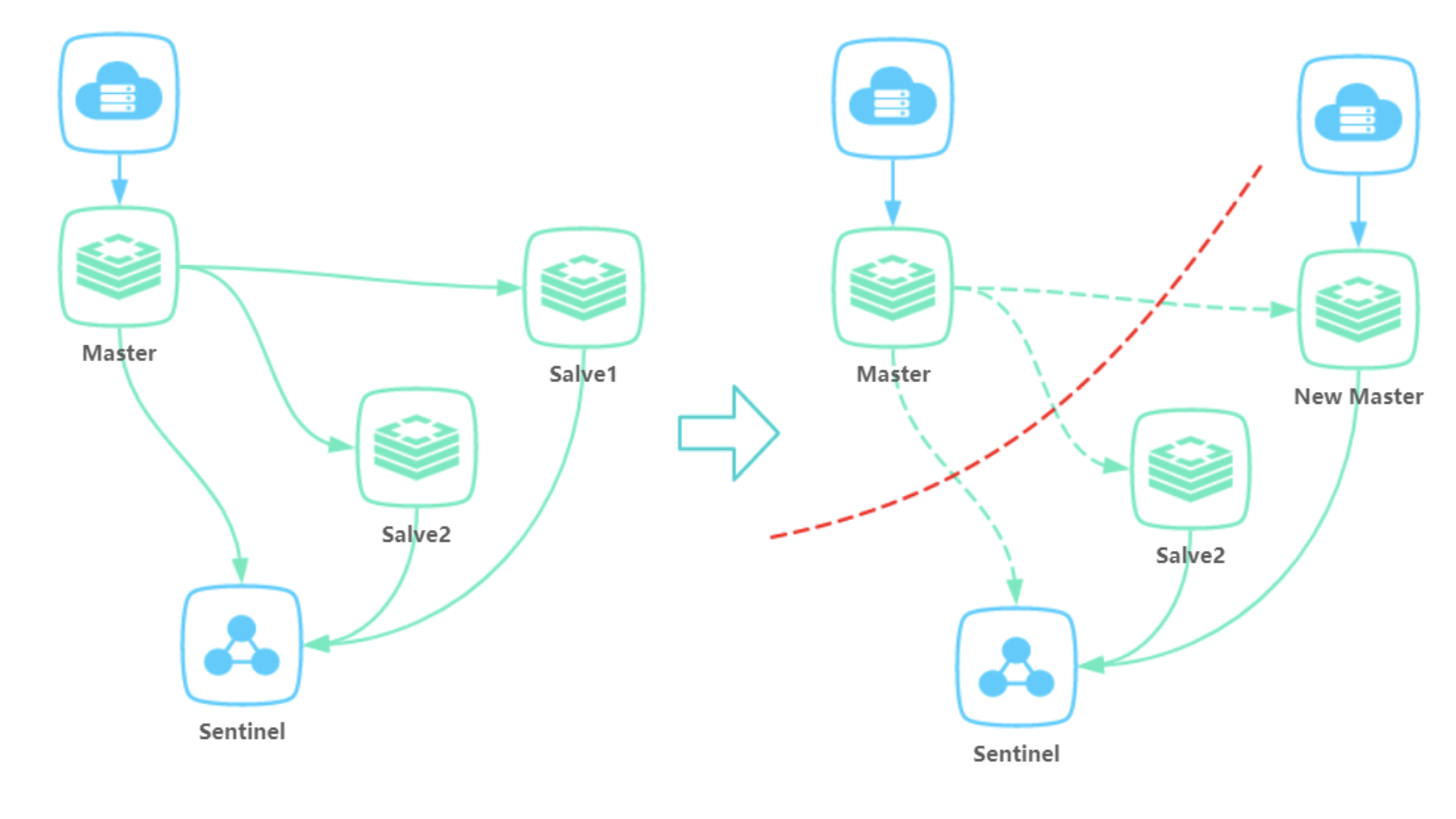

2. 集群脑裂

集群脑裂指因为网络问题,导致 Redis master 节点跟 slave 节点和 sentinel 集群处于不同的网络分区,因为 sentinel 集群无法感知到 master 的存在,所以将 slave 节点提升为 master 节点,此时存在两个不同的 master 节点。Redis Cluster 集群部署方式同理。

当不同的客户端连接不同的 master 节点时,两个客户端可以同时拥有同一把锁。如下:

解决方案:redis的配置文件redis.conf中,存在两个参数

min-replicas-to-write 3

min-replicas-max-lag 10

第一个参数表示连接到master的最少slave数量

第二个参数表示slave连接到master的最大延迟时间

按照上面的配置,要求至少3个slave节点,且数据复制和同步的延迟不能超过10秒,否则的话master就会拒绝写请求,配置了这两个参数之后,如果发生集群脑裂,原先的master节点接收到客户端的写入请求会拒绝,就可以减少数据同步之后的数据丢失。

redis中的异步复制情况下的数据丢失问题也能使用这两个参数

Enjoy Reading This Article?

Here are some more articles you might like to read next: